Facebook relaja su moderación de contenido y los resultados ya se hacen notar

El contenido violento ha aumentado un 0,02% en Facebook después de la relajación de la moderación de contenido

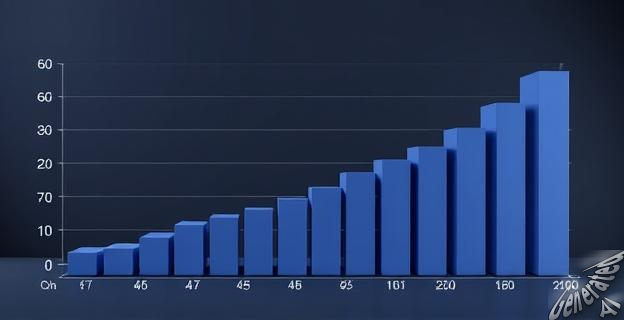

Meta ha publicado su primer informe trimestral de integridad después de modificar las políticas de moderación de contenido en Facebook. Los nuevos datos muestran que, aunque la compañía ha reducido significativamente los errores de moderación, el contenido violento y el acoso han aumentado. El número de publicaciones retiradas por contenido de odio se redujo a 3,4 millones, y las eliminaciones de contenido considerado spam cayeron a la mitad. Sin embargo, el contenido violento subió de un 0,06%-0,07% a un 0,09% del total, y el acoso también aumentó. Meta argumenta que este incremento se debe a que más usuarios están compartiendo este tipo de publicaciones y a que la empresa está siendo más prudente al aplicar sanciones. La compañía ha decidido mantener una moderación más estricta para los usuarios adolescentes y ha comenzado a integrar modelos de lenguaje grandes en sus sistemas de moderación.